美 연구팀 "더 작고 빠른 전자소자 제작 가능...양자컴퓨터에 응용 기대"

우수한 전기·화학적 특성으로 반도체 분야 '꿈의 신소재'로 주목받으면서도 전류 흐름 제어가 어려워 반도체 소재로 활용이 어려웠던 그래핀으로 만든 기능성 반도체가 처음으로 개발됐다.

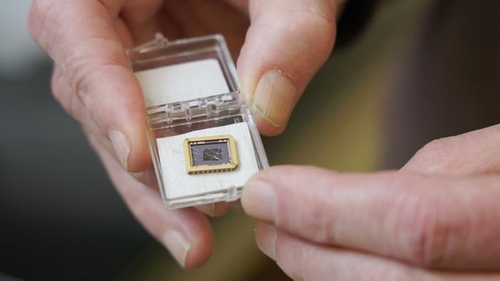

미국 조지아공대(Georgia Tech) 물리학과 월터 드 히어 교수팀은 4일 과학 저널 '네이처'(Nature)에서 탄화규소(silicon carbide) 웨이퍼에 성장시킨 에피택셜 그래핀(epitaxial graphene)으로 기능성 반도체를 만드는 데 성공했다고 밝혔다.

드 히어 교수는 그래핀 반도체를 이용하면 실리콘 반도체보다 더 작고 빠른 장치를 만들 수 있고 양자 컴퓨터에도 응용할 수 있다며 전자공학 역사에서 그래핀이 실리콘 다음 단계가 될 수 있다고 말했다.

그래핀은 탄소 원자가 6각형 벌집 모양으로 결합해 원자 1개 층의 얇은 판을 이루고 있는 물질이다. 강철보다 강하면서도 구리보다 100배 이상 전기가 잘 통하고 실리콘보다 전자를 100배 이상 빠르게 이동시키는 전기적 특성을 가지고 있다.

이 때문에 그래핀은 '꿈의 신소재'로 불리지만 자연 상태에서는 반도체도 금속도 아닌 반금속이어서 전자 소자로 제작하는 데 어려움이 있었다.

이는 그래핀에는 전기장을 이용해 켜고 끌 수 있는 '밴드 갭'(band gap)이라는 전자적 특성이 없기 때문이다. 트랜지스터와 실리콘 반도체는 모두 이 밴드 갭을 이용해 작동한다.

연구팀은 이 연구에서 특수로(special furnaces)를 사용해 탄화규소 웨이퍼 표면에 에피택셜 그래핀을 성장시키는 방법을 알아내 그래핀 밴드 갭 문제에 대한 해결 실마리를 찾았다.

에피택셜 그래핀은 다른 결정(結晶)의 표면에 그래핀 결정을 특정 방향을 갖도록 성장시킨 것으로, 연구팀은 에피택셜 그래핀이 제대로 만들어지면 탄화규소와 화학적으로 결합해 반도체 특성을 보이기 시작한다는 사실을 발견했다.

연구팀이 에피택셜 그래핀으로 반도체를 제작해 측정한 결과 실리콘보다 전자 이동성이 10배 이상 높은 것으로 나타났다. 이는 전자가 매우 낮은 저항을 받으며 이동할 수 있어 반도체 작동 속도를 더 빠르게 만들 수 있음을 시사한다.

연구팀은 그래핀 반도체는 현재로서는 나노 전자공학에서 사용되는 데 필요한 모든 특성을 갖춘 유일한 2차원 반도체라며 현재 개발 중인 다른 어떤 2차원 반도체보다 훨씬 뛰어난 전기적 특성을 가지고 있다고 설명했다.

드 히어 교수는 "이제 우리는 실리콘의 10배에 달하는 이동성을 가진 매우 견고한 그래핀 반도체를 갖게 됐고 이 반도체는 실리콘에서는 볼 수 없는 독특한 특성도 갖고 있다"며 이 연구는 그래핀 전자공학의 문을 연 것이라고 말했다.

연구팀은 거의 모든 전자제품의 소재가 되는 실리콘이 점점 더 빨라지는 컴퓨팅 속도와 전자기기의 극단적 소형화 속에 한계에 직면하고 있다는 점에 주목하며 그래핀 반도체가 실리콘을 대체할 수 있는 대안이 될 것으로 기대한다.

공동 저자인 중국 톈진대 톈진 국제 나노입자 및 나노시스템 센터 레이 마 소장은 "이 연구는 그래핀 전자공학의 오랜 문제점인 밴드 갭(전자가 차 있는 원자가띠와 비어 있는 전도띠 사이에 존재하는 에너지 간격)을 해결한 것"이라며 "이는 그래핀 기반 전자 장치를 구현하기 위한 중요한 진전"이라고 말했다.

연구팀은 특히 에피택셜 그래핀은 그래핀 고유 특성을 이용해 양자 컴퓨터의 필수 요건인 전자의 양자역학적 파동 특성을 활용할 수 있게 해준다며 이 소재가 전자 분야에서 패러다임 전환을 일으킬 수 있다고 기대했다.

드 히어 교수는 "라이트 형제가 비행기를 처음 만들었을 때 회의론자들은 빠른 기차와 배가 있는데 왜 비행기가 필요한지 의문을 제기했었다"며 "(그래핀 반도체 개발은) 나에게 라이트 형제의 순간과 같다"고 말했다.

◆ 출처 : Nature, Walter de Heer et al., 'Ultrahigh-mobility semiconducting epitaxial graphene on silicon carbide', https://www.nature.com/articles/s41586-023-06811-0

<저작권자(c) 연합뉴스, 무단 전재-재배포, AI 학습 및 활용 금지>